[已审核]2025年AI大模型管理工具选型指南:Cherry Studio、Chatbox、AnythingLLM深度对比

随着大模型应用也越来越广,怎么管好这些“数字大脑”就成了个大问题。今天咱们就来好好对比一下三款很火的AI大模型管理工具:Cherry Studio、Chatbox和AnythingLLM。看看它们各自有什么特点,帮你选出最适合你的那一个。

一、工具概览

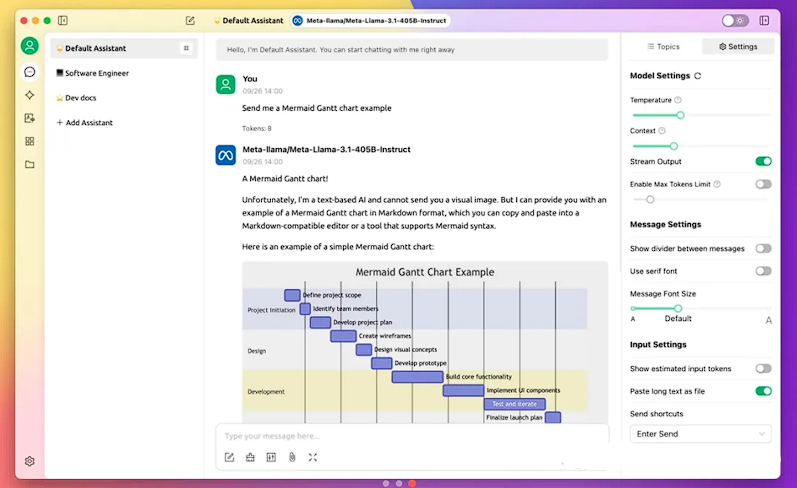

- Cherry Studio

Cherry Studio是个功能很全的开源AI大模型管理工具。它最大的特点就是可以随便切换不同的模型,知识库管理也很强大,还能联网搜索。而且,它可以本地部署,这样数据隐私就能得到很好的保护,定制起来也很方便。Cherry Studio现在已经成了很多开发者和企业的首选。

- Chatbox

Chatbox呢,它比较轻量级,是个对话式的AI工具,用起来很简单,上手很快。它也支持多种大模型,特别适合那些只需要基础对话功能的用户。而且,Chatbox很注重本地数据存储,这样用户的隐私就能得到保障。

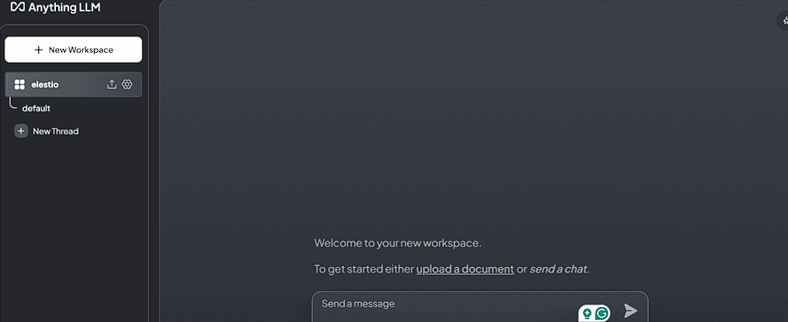

- AnythingLLM

AnythingLLM 是一款企业级的知识库管理工具,它自带向量数据库,还有文档智能问答功能。它特别适合需要处理大量文档、想构建私有知识库的企业和团队。AnythingLLM 同样支持本地化部署,确保数据安全。

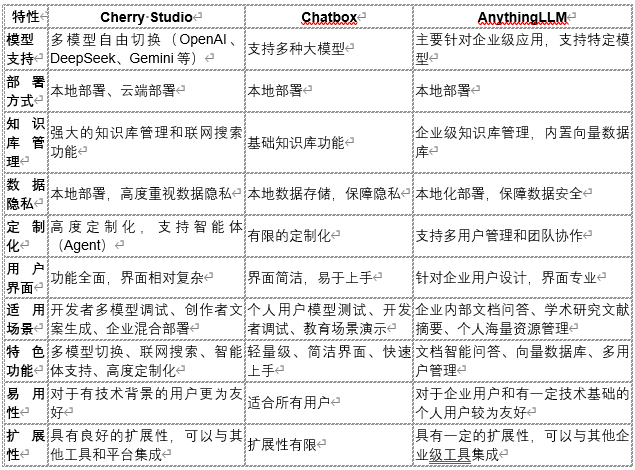

二、功能对比与优势分析

特性 Cherry Studio Chatbox AnythingLLM

见图

三、适用场景深度解析 - Cherry Studio

• 开发者进行多模型对比调试: Cherry Studio 可以让开发者很方便地切换不同的AI大模型,这样就能对比它们的性能,调试效果,效率会提高很多。

• 创作者快速切换不同风格文案生成: 内容创作者可以用 Cherry Studio 快速切换模型,生成各种各样的文案,满足不同的需求。

• 企业需要兼顾数据隐私与云端高性能模型混合使用: Cherry Studio 可以本地部署,这样企业的数据就安全了,而且它还可以连接云端的模型,用起来很灵活。 - Chatbox

• 个人用户快速测试本地模型生成效果: Chatbox 的界面很简单,上手也很快,所以个人用户可以很轻松地测试本地模型的生成效果。

• 开发者临时调试模型或生成简单代码片段: 开发者可以用 Chatbox 临时调试一下模型,或者快速生成一些简单的代码。

• 教育场景中的教学演示工具: Chatbox 可以用来做教学演示,展示AI大模型的基本对话功能。 - AnythingLLM

• 企业内部文档库的自动化问答(如员工手册、技术文档): AnythingLLM 的文档智能问答功能可以帮助企业实现内部文档库的自动化问答,提高员工的工作效率。

• 学术研究中的文献摘要与关键信息提取: AnythingLLM 可以帮助研究人员快速提取文献摘要和关键信息,加速科研进程。

• 个人用户管理海量笔记或电子书资源: 个人用户可以利用 AnythingLLM 管理大量的笔记或电子书资源,构建个人知识库。

四、选型建议 - 全能选手,技术先锋:Cherry Studio如果你是技术团队,或者需要处理很多任务,而且对数据隐私和功能扩展性要求比较高,那 Cherry Studio 绝对是首选。它支持多种模型,知识库管理也很强大,定制起来也很方便,简直就是AI大模型管理工具里的“全能选手”。

- 知识管理专家,企业首选:AnythingLLM如果你的主要需求是处理文档,想构建企业级的私有知识库,那 AnythingLLM 就是你的理想选择。它的文档智能问答功能很棒,还有向量数据库,可以进行多用户管理,绝对是企业知识管理的“专家”。

- 轻量级对话,快速上手:Chatbox如果你只是需要一个简单的对话式AI工具,那 Chatbox 就是你的最佳选择。它的界面简洁,上手很快,而且数据存在本地,用起来很方便,对个人用户、开发者和教育工作者来说,它就是个“轻量级”的选择。

五、写在最后

Cherry Studio、Chatbox 和 AnythingLLM 都有自己的特点。选哪个工具,关键还是要看你的需求。不管你是技术大牛,还是企业领导,或者追求效率的人,总有一款工具能帮到你。所以,赶紧行动起来,选一个最适合你的工具,让AI真正帮你提高工作和生活质量!

收到5条评论

JosephBut 2 个月前

我非常尊敬, 真实的旅行者分享建议。这个页面 就是 属于这里的。加油。 <a href=https://iqvel.com/zh-Hans/a/%E5%9D%A6%E6%A1%91%E5%B0%BC%E4%BA%9A/%E6%81%A9%E6%88%88%E7%BD%97%E6%81%A9%E6%88%88%E7%BD%97%E4%BF%9D%E6%8A%A4%E5%8C%BA>火山口草原</a> 我珍视, 这里展示真正的旅游。你的项目 就是 这样的。加油。

回复

Alvin 2 个月前

目前在使用ChatHub,感觉也还可以

回复

qwe 7 个月前

牛哇牛哇,有没有关于网络安全之类的东西?

回复

Alvin 9 个月前

补充:核心配置步骤

1. 获取API密钥

2. • 推荐平台:硅基流动(新用户送2000万Tokens)、腾讯云、MKEAI中转站等

3. • 密钥保存:登录对应平台 → 创建API密钥(如硅基流动在「API密钥」菜单生成)

4. 各大模型管理器客户端设置

5. • 模型提供方:如选择 OpenAI API(兼容多数平台)

6. • API密钥:粘贴获取的密钥

7. • API域名:根据平台填写(如硅基流动用 https://cloud.siliconflow.cn)

8. • 自定义模型名:格式为 平台标识@模型名称(例:siliconflow@deepseek-ai/DeepSeek-R1)

9. 联网搜索功能(可选)

10. • 使用中转接口如 https://search-for-llmapi.dawne.cn/with-search/v1/ 可实现联网

1. 获取API密钥

2. • 推荐平台:硅基流动(新用户送2000万Tokens)、腾讯云、MKEAI中转站等

3. • 密钥保存:登录对应平台 → 创建API密钥(如硅基流动在「API密钥」菜单生成)

4. 各大模型管理器客户端设置

5. • 模型提供方:如选择 OpenAI API(兼容多数平台)

6. • API密钥:粘贴获取的密钥

7. • API域名:根据平台填写(如硅基流动用 https://cloud.siliconflow.cn)

8. • 自定义模型名:格式为 平台标识@模型名称(例:siliconflow@deepseek-ai/DeepSeek-R1)

9. 联网搜索功能(可选)

10. • 使用中转接口如 https://search-for-llmapi.dawne.cn/with-search/v1/ 可实现联网

回复

Alvin 9 个月前

《ollama+dify搭建本地知识库》

地址git : https://github.com/ollama/ollama

1 install

1.1 mac ,直接点击下载

复制地址到浏览器直接下载:https://ollama.com/download/Ollama-darwin.zip

1.2 windows:

https://ollama.com/download/OllamaSetup.exe

1.3 linux

curl -fsSL https://ollama.com/install.sh | sh

2 使用

2.1 启动ollama

mac 修改ip **

默认ip为127.0.0.1,最好修改为0.0.0.0

OLLAMA_HOST 环境变量

vim ~/.zshrc

export OLLAMA_HOST='0.0.0.0'

source ~/.zshrc

launchctl setenv OLLAMA_HOST "0.0.0.0"查看 netstat -an | grep 11434 是否0 *.11434,而不是 127.0.0.1.11434

linux修改ip:

sudo systemctl stop ollama

修改ip地址

/etc/systemd/system/ollama.service

sudo systemctl daemon-reload

sudo systemctl restart ollama

2.2 运行模型

大模型

1️⃣ ollama 官方自带模型

模型搜索网址:https://ollama.com/library

如:ollama run qwen:0.5b

2️⃣ 运行自定义模型(需要转转换为gguf文件)

1 文件写入

下载一个gguf文件:如llama3.1_8b_chinese

https://modelscope.cn/models/XD_AI/Llama3.1-8B-Chinese-Chat/resolve/master/gguf/llama3.1_8b_chinese_chat_q4_k_m.gguf

将这行内容写入 一个文件如:llama_zh:FROM .llama3.1_8b_chinese_chat_q4_k_m.gguf

2 创建ollama文件

llamazh为自定义的模型名字,如上面的qwen:0.5b一样的名字

ollama create llama3.1:8bzh -f llama_zh

3 查看或运行自定义模型

查看已经下载的模型:ollama list

运行模型:ollama run llama3.1:8bzh

embedding 模型

ollama pull shaw/dmeta-embedding-zh-small

2.3 ollma命令

删除:ollama rm llama3.1

服务:ollama server

3 整合Dify

mac: 解决docker ip问题:

https://docs.dify.ai/v/zh-hans/guides/model-configuration/ollama

https://github.com/langgenius/dify/issues/2854

http://host.docker.internal:11434

地址git : https://github.com/ollama/ollama

1 install

1.1 mac ,直接点击下载

复制地址到浏览器直接下载:https://ollama.com/download/Ollama-darwin.zip

1.2 windows:

https://ollama.com/download/OllamaSetup.exe

1.3 linux

curl -fsSL https://ollama.com/install.sh | sh

2 使用

2.1 启动ollama

mac 修改ip **

默认ip为127.0.0.1,最好修改为0.0.0.0

OLLAMA_HOST 环境变量

vim ~/.zshrc

export OLLAMA_HOST='0.0.0.0'

source ~/.zshrc

launchctl setenv OLLAMA_HOST "0.0.0.0"查看 netstat -an | grep 11434 是否0 *.11434,而不是 127.0.0.1.11434

linux修改ip:

sudo systemctl stop ollama

修改ip地址

/etc/systemd/system/ollama.service

sudo systemctl daemon-reload

sudo systemctl restart ollama

2.2 运行模型

大模型

1️⃣ ollama 官方自带模型

模型搜索网址:https://ollama.com/library

如:ollama run qwen:0.5b

2️⃣ 运行自定义模型(需要转转换为gguf文件)

1 文件写入

下载一个gguf文件:如llama3.1_8b_chinese

https://modelscope.cn/models/XD_AI/Llama3.1-8B-Chinese-Chat/resolve/master/gguf/llama3.1_8b_chinese_chat_q4_k_m.gguf

将这行内容写入 一个文件如:llama_zh:FROM .llama3.1_8b_chinese_chat_q4_k_m.gguf

2 创建ollama文件

llamazh为自定义的模型名字,如上面的qwen:0.5b一样的名字

ollama create llama3.1:8bzh -f llama_zh

3 查看或运行自定义模型

查看已经下载的模型:ollama list

运行模型:ollama run llama3.1:8bzh

embedding 模型

ollama pull shaw/dmeta-embedding-zh-small

2.3 ollma命令

删除:ollama rm llama3.1

服务:ollama server

3 整合Dify

mac: 解决docker ip问题:

https://docs.dify.ai/v/zh-hans/guides/model-configuration/ollama

https://github.com/langgenius/dify/issues/2854

http://host.docker.internal:11434

回复